Аннотация:

В статье рассматривается влияние искусственного интеллекта (ИИ) на юридическую практику, выделяются как преимущества, так и риски его использования. Анализируются ключевые статистические данные о внедрении ИИ в юридических фирмах, типичные ошибки при работе с ИИ, в том числе доверие к недостоверным результатам и проблемы конфиденциальности. Особое внимание уделяется необходимости тщательного тестирования ИИ-инструментов в реальных условиях и критическому подходу к их применению. Автор подчёркивает, что ИИ дополняет, но не заменяет юридическое мышление и ответственность.Введение: технологии меняют юридический ландшафт

Юридическая профессия переживает момент принципиального перелома. То, что ещё вчера воспринималось как высокотехнологичный эксперимент, сегодня становится частью повседневной практики. Искусственный интеллект, некогда рассматривавшийся как угроза или далекая перспектива, теперь уверенно занимает место в кабинете юриста — наравне с кодексами и судебной практикой.Только вдумайтесь:

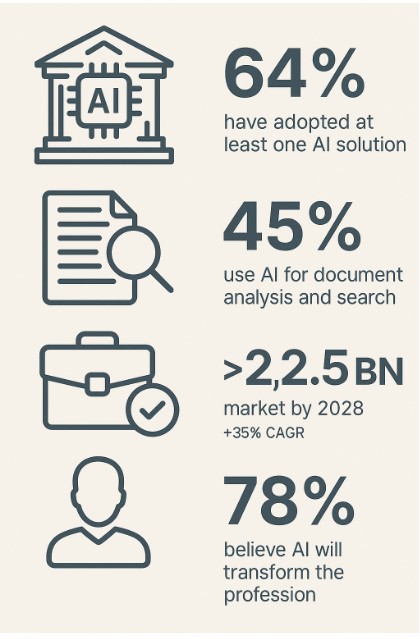

- 64% юридических фирм уже внедрили как минимум одно ИИ-решение для повышения эффективности;

- 45% используют ИИ для анализа и поиска документов;

- более 53% отмечают, что такие инструменты помогли им ускорить рассмотрение дел и повысить продуктивность;

- прогнозируется, что к 2028 году рынок юридического ИИ вырастет до $2,5 млрд со среднегодовым темпом роста в 35%;

- и, наконец, 78% юристов уверены: ИИ кардинально повлияет на будущее профессии.

Но с расширением возможностей растёт и цена ошибки. За удобством ИИ скрыты алгоритмические ловушки, уязвимости в защите данных, слепые зоны интерпретации. Поэтому перед тем как внедрять такие инструменты, важно не только восхищаться скоростью их работы, но и трезво оценивать их ограничения.

Об этом и пойдёт речь в статье — о типичных ошибках при использовании ИИ в юридической практике и о том, как тестировать технологии до того, как доверить им реальную юридическую ответственность.

Где чаще всего ошибаются: иллюзия нейтрального помощника

Одна из ключевых проблем — соблазн безоговорочно доверять результатам, выданным ИИ. Когда система быстро выдает анализ договора или «предсказывает» шансы выиграть дело, легко забыть, что это не юридическое заключение, а результат машинной обработки данных. И если эти данные были неполными, устаревшими или нерелевантными, итог может оказаться не просто неточным — он будет вводящим в заблуждение.На практике это уже привело к дисциплинарным последствиям. В деле Mata v. Avianca, Inc. (США, 2023) адвокаты представили в суде несуществующие прецеденты, сгенерированные ChatGPT, и были оштрафованы на $5 000. Год спустя, в 2025-м, аналогичный случай произошёл в деле о банкротстве: адвокат Томас Нильд был оштрафован на $5 500 за использование четырёх вымышленных дел, также полученных от ИИ. Эти инциденты демонстрируют, насколько опасна иллюзия нейтрального и «всегда знающего» помощника.

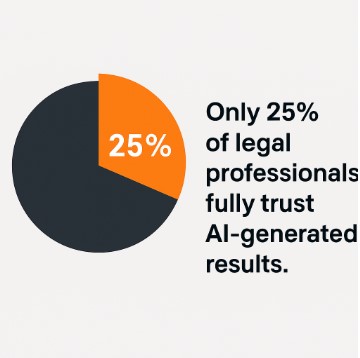

Юристы, не имеющие технической подготовки, нередко воспринимают ИИ как «чёрный ящик», результат которого кажется неоспоримым. Согласно опросу LexisNexis, хотя 37% фирм уже используют ИИ в работе, лишь 25% юристов полностью доверяют результатам таких систем. Это свидетельствует о глубоком разрыве между технологическим оптимизмом и профессиональным скепсисом.

При этом за фасадом нейросетей скрываются вполне конкретные ограничения: отсутствие обновлённой базы законодательства, игнорирование региональных различий, неспособность распознавать юридические нюансы в двусмысленных формулировках.

Не менее тревожный момент — конфиденциальность. Погоня за эффективностью порой подталкивает к использованию онлайн-инструментов без должной правовой экспертизы. Документы загружаются на внешние серверы, ИИ получает доступ к персональным и корпоративным данным — и вся система защиты клиента оказывается под угрозой. Особо остро стоит вопрос интерпретируемости. Если юристу сложно объяснить, почему ИИ принял то или иное решение — значит, использовать этот инструмент в реальной юридической работе опасно. Юридическое мышление требует прозрачности, а не «магии» статистических моделей. И здесь встаёт этическая граница: можно ли использовать выводы, которые невозможно верифицировать? Таким образом, случаи с явно фальшивыми судебными ссылками показывают: доверять ИИ без проверки опасно. Реальные штрафы, дисциплинарные меры и устойчивый скепсис среди юристов — всё это говорит, что автоматизация требует профессиональной ответственности. ИИ может быть полезен, но не заменяет критику, проверку и ответственность юриста.

Как выбирать ИИ-инструменты: не на веру, а по проверке

Для того чтобы ИИ стал не источником риска, а надёжным помощником, одной интуиции или восторгов по поводу технологий недостаточно. Здесь необходим системный подход — сравнительное тестирование. Причём не в лабораторных условиях, а в приближении к реальным задачам практикующих юристов.Такое тестирование начинается не с кода, а с вопросов: что именно мы хотим автоматизировать? Какая проблема решается? Нужно ли ускорить анализ судебной практики? Или снизить нагрузку на юридический отдел при проверке контрактов? Ответы на эти вопросы позволяют не подстраиваться под возможности конкретной платформы, а выбирать инструмент под свои задачи.

Далее идёт отбор тестов: стандартные кейсы, реальные документы, типовые запросы. Разные системы ИИ — от простых поисковиков до полноценных аналитических платформ — проверяются в равных условиях. Где-то система оказывается сильна в точном поиске по ключевым словам, но не способна работать с контекстом. Где-то — наоборот, понимает юридическую логику, но путается в классификации. Иногда система уверенно "выдаёт" несуществующее решение суда, подражая уверенности человека — классическая галлюцинация.

Параллельно анализируется, насколько удобно работать с системой: понятен ли интерфейс, можно ли корректировать ответы, позволяет ли ИИ обучение на базе собственной практики? Без этого говорить о долгосрочной ценности инструмента невозможно.

В результате такого тестирования не просто выбирается “лучшая система” — формируется понимание, что именно стоит внедрять, где ИИ действительно помогает, а где — всё ещё требует присутствия живого разума.

Заключение: технологии усиливают, но не заменяют мышление

ИИ в юридической практике — это вызов, который требует зрелости. Он даёт возможности, но одновременно предъявляет требования: к качеству данных, к способности критически осмысливать результат, к умению сочетать технологический подход с юридической ответственностью. Пока одни ждут от ИИ революции, другие уже работают над тем, чтобы сделать эту трансформацию управляемой. И выигрывают, как правило, не те, кто первым внедрил модную платформу, а те, кто научился понимать и оценивать её ограниченность.ИИ — это не конкурент юристу. Это продолжение его инструментов. Но только в том случае, если сам юрист не отказывается от главного инструмента профессии — от мышления. Список источников: TOI Tech Desk. US lawyer uses ChatGPT to cite fake legal cases: Judge imposes fine; warns ChatGPT can write a story, but… // Times of India. — 2025. — 31 July. — URL: https://timesofindia.indiatimes.com/technology/tech-news/us-lawyer-uses-chatgpt-to-cite-fake-legal-cases-judge-imposes-fine-warns-chatgpt-can-write-a-story-but/articleshow/123022119.cms

GITNUXREPORT. AI in the Law Firm Industry Statistics. — 2025. — URL: https://gitnux.org/ai-in-the-law-firm-industry-statistics/

WifiTalents Team. AI in the Legal Industry Statistics. AI adoption boosts legal efficiency, accuracy, and innovation across firms globally. — Published June 1, 2025. — URL: https://wifitalents.com/ai-in-the-legal-industry-statistics/